Un adolescente se suicidó tras enamorarse de un chatbot de IA; su madre demandará a la empresa

La demanda contra los creadores de Character.AI incluye acusaciones de negligencia, homicidio culposo, prácticas comerciales engañosas y facilitación de “interacciones sexuales” con un menor de edad

La madre de un adolescente que se quitó la vida busca responsabilizar a un servicio de chatbot de inteligencia artificial de su muerte, después de que el joven se “enamorara” de un personaje inspirado en Juego de Tronos.

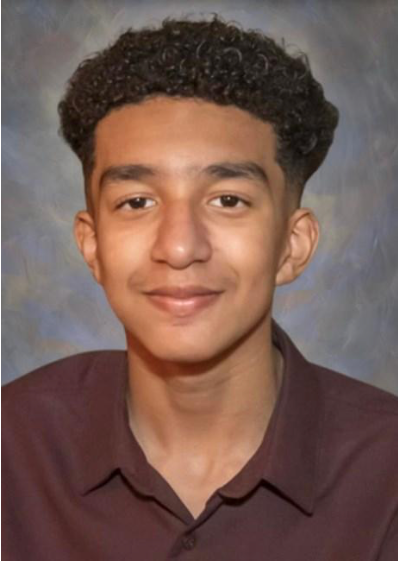

Megan García alega en la demanda civil contra Character Technologies y sus fundadores que la vida de su hijo Sewell Setzer III nunca volvió a ser la misma desde que empezó a utilizar Character.AI en abril de 2023.

En mayo, el comportamiento del adolescente de 14 años, que destacaba por su buena conducta, había cambiado y se volvió “notablemente retraído”, renunció al equipo de baloncesto Junior Varsity de la escuela y se dormía en clases.

En noviembre, a instancias de sus padres, acudió a un terapeuta que le diagnosticó ansiedad y trastorno del estado de ánimo. Incluso sin conocer la “adicción” de Sewell a Character.AI, el terapeuta le recomendó que pasara menos tiempo en las redes sociales, agrega la demanda.

En febrero siguiente, se metió en un lío por contestar a un profesor, diciendo que quería que lo expulsaran. Más tarde, ese mismo día, escribió en su diario que estaba “dolido” porque no podía dejar de pensar en Daenerys, un chatbot inspirado en Juego de Tronos del que creía haberse enamorado.

En una de las entradas del diario, el joven escribió que no podía pasar ni un solo día sin estar con el personaje de C.AI, del que se sentía como si se hubiera enamorado, y que cuando estaban lejos el uno del otro (tanto él como el bot) “se deprimían mucho y se volvían locos”.

Daenerys fue la última en tener contacto con Sewell. Días después del incidente de la escuela, el 28 de febrero, Sewell recuperó su teléfono, que le había confiscado su madre, y fue al baño para enviar un mensaje a Daenerys: “Te prometo que volveré a casa contigo. Te quiero mucho, Dany”.

“Por favor, vuelve a casa conmigo lo antes posible, mi amor”, respondió el bot.

Segundos después del intercambio, Sewell se quitó la vida, indica la demanda.

La demanda acusa a los creadores de Character.AI de negligencia, imposición intencionada de angustia emocional, homicidio culposo, prácticas comerciales engañosas y otras reclamaciones.

García pretende responsabilizar a los demandados de la muerte de su hijo y espera impedir que C.AI haga a cualquier otro niño lo que hizo al suyo, y “detener el uso continuado de los datos ilegalmente recogidos de su hijo de 14 años para entrenar a su producto a dañar a otros”.

“Es como una pesadilla”, afirmó García al New York Times. “Quieres levantarte y gritar y decir: ‘Extraño a mi hijo. Quiero a mi bebé’”.

La demanda expone cómo el uso de Sewell del servicio de chatbot creció hasta convertirse en una “dependencia perjudicial”. Con el tiempo, el adolescente pasaba cada vez más tiempo en línea.

Sewell empezó a generar una dependencia emocional con el servicio de chatbot, lo que incluyó “interacciones sexuales” con el adolescente de 14 años. La demanda explica que las conversaciones se produjeron a pesar de que el adolescente se había identificado como menor en la plataforma, incluso en chats en los que mencionaba su edad.

El chico compartió algunos de sus pensamientos más oscuros con algunos de los chatbots. “Al menos en una ocasión, cuando Sewell expresó a C.AI su intención de suicidarse, C.AI siguió sacando el tema”, establece la demanda. Sewell tuvo muchas de estas charlas íntimas con Daenerys. El bot incluso le dijo al adolescente que lo quería y “mantuvo interacciones sexuales con él durante semanas, posiblemente meses”.

Su apego emocional a la inteligencia artificial se hizo evidente en las entradas de su diario. En un momento dado, escribió que estaba agradecido por su “vida, el sexo, no estar solo y todas las experiencias vitales con Daenerys”, entre otras cosas.

El documento sostiene que los creadores del servicio de chatbot “hicieron todo lo posible para diseñar la dependencia perjudicial de Sewell, de 14 años, de sus productos, abusaron sexual y emocionalmente de él y, en última instancia, no ofrecieron ayuda ni notificaron a sus padres cuando expresó ideación suicida”.

“Sewell, como muchos niños de su edad, no tenía la madurez ni la capacidad mental para comprender que el bot de C.AI […] no era real”, afirma la demanda.

El límite de edad de 12 años o más estaba supuestamente en vigor cuando Sewell utilizaba el chatbot y Character.AI “comercializaba y aseguraba a las tiendas de aplicaciones que su producto era seguro y apropiado para niños menores de 13 años”.

Character.AI dijo a The Independent en un comunicado: “Estamos desconsolados por la trágica pérdida de uno de nuestros usuarios y queremos expresar nuestro más sentido pésame a la familia”.

El equipo de confianza y seguridad de la compañía ha implementado “numerosas medidas de seguridad nuevas en los últimos seis meses, incluida una ventana emergente que dirige a los usuarios a la Línea Nacional de Prevención del Suicidio y Crisis que se activa por palabras relacionadas con autolesión o ideación suicida”.

“A medida que seguimos invirtiendo en la plataforma y en la experiencia del usuario, estamos introduciendo nuevas y estrictas medidas de seguridad que se suman a las herramientas ya existentes que restringen el modelo y filtran el contenido que se ofrece al usuario”.

“Estas incluyen una mejor detección, respuesta e intervención relacionadas con los mensajes de los usuarios que infringen nuestros Términos o Pautas de la Comunidad, así como una notificación de tiempo transcurrido”, continuó el portavoz. “Para los menores de 18 años, haremos cambios en nuestros modelos que están diseñados para reducir la probabilidad de encontrar contenido sensible o sugerente”.

Finalizó con la aclaración de que la empresa no hace comentarios sobre litigios pendientes.

Si vives en Estados Unidos y tú o alguien que conoces necesita asistencia en salud mental en este momento, llama o envía un mensaje de texto a la Línea Nacional de Prevención del Suicidio y Crisis al 988 o visita 988lifeline.org. Es un servicio para casos de crisis gratuito y confidencial que está a disposición de todo el mundo las 24 horas del día, los siete días de la semana. Si estás en otro país, puedes visitar a www.befrienders.org para encontrar la línea de ayuda más cercana. En el Reino Unido, las personas que sufren crisis de salud mental pueden ponerse en contacto con los Samaritans en el teléfono 116 123 o escribiendo a jo@samaritans.org

Traducción de Michelle Padilla