La prueba de Tom Cruise demuestra que la gente no puede detectar los vídeos falsos aunque sepa que lo son

Exclusiva: la dificultad para identificar deepfakes “amenaza con reducir por completo el valor informativo de los medios de vídeo”, advierten los investigadores

La mayoría de las personas son incapaces de decir que están viendo un vídeo deepfake incluso cuando se les informa de que el contenido que están viendo podría haber sido alterado digitalmente, según sugiere una investigación.

El término deepfake se refiere a un vídeo en el que se ha utilizado la inteligencia artificial y el aprendizaje profundo -un método de aprendizaje algorítmico utilizado para entrenar a las computadoras- para hacer que una persona parezca decir algo que no ha dicho.

Ejemplos notables de ello incluyen un vídeo manipulado del discurso presidencial de Richard Nixon en el Apolo 11 y a Barack Obama insultando a Donald Trump - con algunos investigadores sugiriendo que el uso ilícito de la tecnología podría convertirla en la forma más peligrosa de crimen en el futuro.

En el primer experimento, realizado por investigadores de la Universidad de Oxford, la Universidad de Brown y la Royal Society, un grupo de participantes vio cinco vídeos sin alterar, mientras que otro vio cuatro vídeos sin alterar y un deepfake, y se pidió a los espectadores que detectaran cuál de ellos era falso.

La investigación se realizó como parte de un reporte de la Royal Society sobre cómo la tecnología está cambiando la información en línea, que se publicará la próxima semana. En él se advierte del aumento de la desinformación y se señala a los deepfakes como un área en la que es necesario seguir trabajando para limitar los daños.

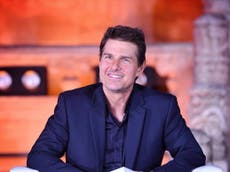

Los científicos utilizaron vídeos de Tom Cruise creados por el artista de efectos visuales Chris Ume, en los que se ve al actor estadounidense haciendo trucos de magia y contando chistes sobre Mijaíl Gorbachov en vídeos subidos a TikTok.

Los participantes que recibieron la advertencia de antemano identificaron el deepfake en un 20 por ciento, frente al 10 por ciento que no lo hizo, pero incluso con una advertencia directa más del 78 por ciento de las personas no pudieron distinguir el deepfake del contenido auténtico.

“Los individuos no son más propensos a notar algo fuera de lo normal cuando se exponen a un vídeo deepfake de contenido neutro”, escribieron los investigadores en una publicación previa del trabajo, “en comparación con un grupo de control que solo vio vídeos auténticos”. Se espera que el trabajo se publique, y sea revisado por pares, en unos meses.

Independientemente de la familiaridad de los participantes con Cruise, el género, el nivel de uso de las redes sociales o su confianza en poder detectar un vídeo alterado, todos mostraron los mismos errores.

La única característica que se correlaciona significativamente con la capacidad de detectar un deepfake fue la edad, según los investigadores, ya que los participantes de más edad eran más capaces de identificar el deepfake.

“La dificultad de detectar manualmente los vídeos reales de los falsos (es decir, a simple vista) amenaza con reducir por completo el valor informativo de los medios de vídeo”, predicen los investigadores.

“A medida que la gente interiorice la capacidad de engaño de los deepfakes, racionalmente depositará menos confianza en todos los vídeos online, incluidos los contenidos auténticos”.

Si esto continúa en el futuro, la gente tendrá que confiar en las etiquetas de advertencia y en la moderación de contenidos en las redes sociales para garantizar que los vídeos engañosos y otra información errónea no se conviertan en algo endémico en las plataformas.

“La pregunta que nos planteamos es: cuando te advierten de que un vídeo puede ser un deepfake, ¿es eso suficiente para que el usuario medio de Internet detecte las señales por sí mismo? Nuestra investigación sugiere que, para la mayoría de la gente, no lo es”, indicó The Independent el autor principal, Andrew Lewis, investigador de doctorado en el Centro de Ciencias Sociales Experimentales de la Universidad de Oxford.

“Esto significa que tendremos que depender -y confiar- en los sistemas de moderación de las plataformas que todos utilizamos”.

Facebook, Twitter y otros sitios dependen de que los usuarios habituales marquen los contenidos a sus moderadores, una tarea que podría resultar difícil si la gente no es capaz de distinguir la desinformación del contenido auténtico.

Facebook, en particular, ha sido criticado en repetidas ocasiones por no proporcionar suficiente apoyo a sus moderadores de contenidos y por no eliminar los contenidos falsos. Una investigación de la Universidad de Nueva York y de la Universidad Grenoble Alpes de Francia descubrió que, entre agosto de 2020 y enero de 2021, los artículos de conocidos proveedores de desinformación recibieron seis veces más likes, acciones e interacciones que los artículos de noticias legítimas.

Facebook sostuvo que este tipo de investigación no muestra la imagen completa, ya que “el compromiso [con las páginas] no debe ... confundirse con la cantidad de personas que realmente lo ven en Facebook”.

Los investigadores también expresaron su preocupación por el hecho de que “estas advertencias puedan ser consideradas como políticamente motivadas o tendenciosas”, como demuestran las teorías de conspiración en torno a la vacuna covid-19 o el etiquetado de Twitter de los tuits del expresidente Trump.

El deepfake del presidente Obama llamando al entonces presidente Trump “un tarado total y completo” fue considerado acertado por el 15 por ciento de las personas en un estudio de 2020, a pesar de que el contenido en sí era “altamente improbable”.

Los investigadores advierten que la desconfianza general en la información en línea es un posible resultado tanto de los deepfakes como de las advertencias de contenido, y “los responsables políticos deberían tenerlo en cuenta a la hora de evaluar los precios y beneficios de la moderación de los contenidos en línea”.