Creador de ChatGPT cree que hay un 50% de riesgo de que la inteligencia artificial acabe en “desgracia”

Las advertencias sobre un apocalipsis por inteligencia artificial van en aumento

Uno de los creadores de ChatGPT se suma a un creciente coro de investigadores que advierten sobre las consecuencias potencialmente catastróficas que implica el desarrollo de la inteligencia artificial.

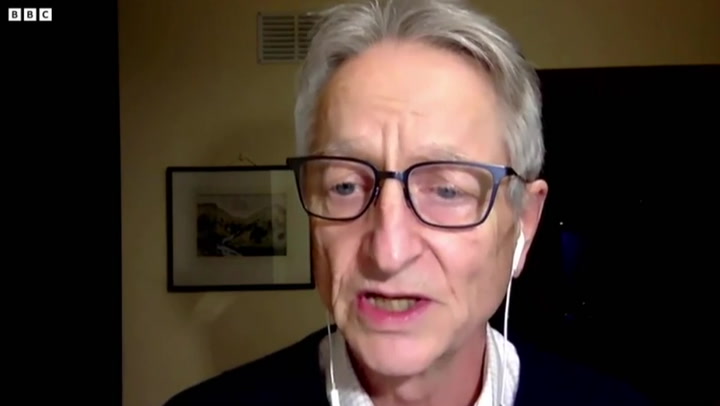

El exempleado de OpenAI, Paul Christiano, quien ahora dirige el Alignment Research Center, una organización sin fines de lucro, cree que hay una posibilidad significativa de que la tecnología provoque la destrucción de la humanidad.

El principal peligro, afirmó, vendrá cuando los sistemas de IA alcancen y superen la capacidad cognitiva de un ser humano. El Dr. Christiano predice que hay una probabilidad del “50% de riesgo de desgracia” una vez que llegue tal momento.

“Tiendo a imaginar algo así como la transición de un año de sistemas de IA que sean bastante trascendentales, a una especie de cambio acelerado, seguido de una mayor aceleración, etcétera”, le dijo al pódcast Bankless.

“Creo que una vez que tienes esa perspectiva, muchas cosas pueden sentirse como problemas de IA porque suceden muy poco tiempo después de desarrollar la IA”.

Agregó: “La forma más probable en que moriríamos no sería que la IA sale de la nada y mata a todos, sino que implica que hayamos desplegado una gran cantidad de IA en todas partes… Y si por alguna razón, Dios no lo quiera, todos estos sistemas de IA intentaran matarnos, definitivamente nos matarían”.

Los comentarios surgen en medio de una creciente preocupación por el rápido avance de la inteligencia artificial en los últimos meses; el supuesto padrino de la IA, Geoffrey Hinton, renunció a Google para hacer sonar la alarma sobre los peligros de la IA.

Al hablar con The New York Times, dijo que lamentaba el trabajo con el que había contribuido al campo debido al futuro impredecible al que nos enfrentamos ahora.

“Algunos creían en la idea de que estas cosas en realidad podrían volverse más inteligentes que las personas”, señala. “Pero la mayoría de la gente pensaba que estaba muy lejos. Yo pensaba que estaba muy lejos. Supuse que faltaban entre 30 y 50 años o incluso más. Obviamente, ya no pienso así”.

"Creo que se deberían frenar los trabajos en este ámbito hasta que se entienda bien si sería posible controlar la IA".

Otros investigadores aplaudieron su postura, y Catherine Olsson de la compañía de seguridad e investigación sobre inteligencia artificial AnthropicAI dice que puede animar a otros dentro del campo a hablar.

“En la universidad dejé de comer carne, en el acto, cuando un amigo me preguntó por qué todavía no lo había hecho. Los controles sociales sobre nuestra ética pueden ser bastante poderosos”, tuiteó. “A menudo pienso en cuándo dejaría Anthropic o abandonaría la IA por completo. Animo a otros a hacerlo. Me estoy dando cuenta de que las declaraciones públicas recientes tendrán un impacto definitivo en mis futuras decisiones”.

Otras figuras destacadas también han instado a las empresas de inteligencia artificial a frenar el desarrollo de sistemas avanzados, más recientemente a través de una carta abierta firmada por miles de expertos que insta a los gobiernos a intervenir si el desarrollo de la inteligencia artificial no se detiene durante al menos seis meses.

Entre los firmantes estaba Elon Musk, quien ha abordado con frecuencia sobre la amenaza existencial que representa la IA. El multimillonario tecnológico, cofundador de OpenAI, tuiteó el lunes: “Incluso la dependencia benigna de la IA/automatización es peligrosa para la civilización si llega al punto en que finalmente olvidamos cómo funcionan las máquinas”.

Traducción de Michelle Padilla